Robots.txt는 무엇인가?

2023-10-11

Robots.txt는 무엇인가?

Robots.txt란 검색 엔진 스파이더에게 웹사이트 특정 페이지나 섹션을 크롤링하지 않도록 지시하는 파일이다.

대부분 주요 검색 엔진 구글, 빙, 네이버 등은 Robots.txt 요청을 인식한다.

Robots.txt가 중요한 이유

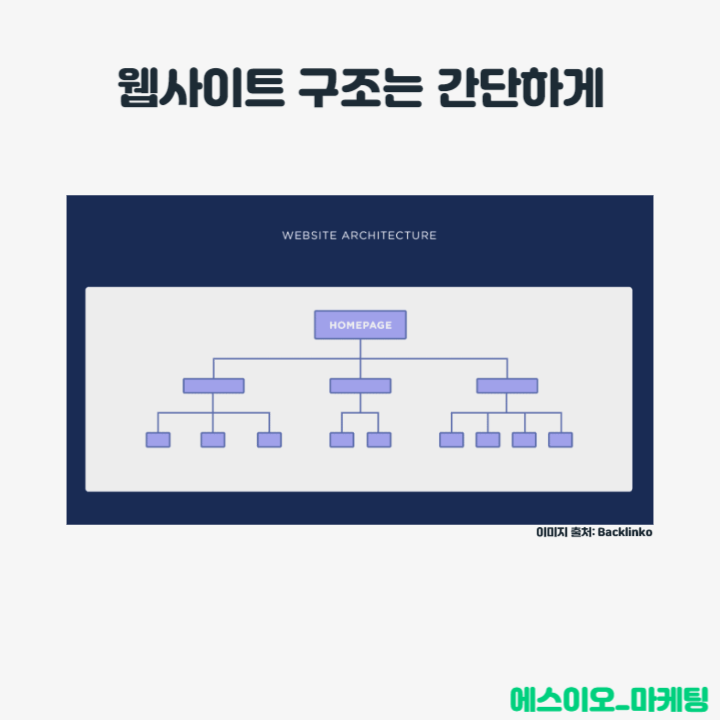

대부분 웹사이트는 robots.txt 파일이 필요하지 않는다.

구글이 사이트의 모든 페이지를 찾아 색인을 생성할 수 있기 때문이다.

중요하지 않은 페이지나 중복 페이지는 자동으로 색인화하지 않는다.

하지만, Robots.txt를 사용하는 이유는 크게 3가지이다.

1. 비공개 페이지 차단

사이트에 색인을 생성하고 싶지 않은 페이지가 있는 경우가 있다.

예를 들어, 로그인 페이지는 노출 시킬 필요가 없다.

따라서 Robot.txt를 사용하여 검색 엔진 크롤러 및 봇으로부터 해당 페이지를 차단하는 경우이다.

2. 크롤링 예산 최대화

모든 페이지 색인을 생성하는 데 어려움을 겪고 있다면 크롤링 예산 문제가 발생할 수 있다.

Robots.txt를 사용하여 중요하지 않은 페이지를 차단함으로써 구글봇은 실제로 중요한 페이지에 크롤링 예산을 더 많이 사용할 수 있다.

3. 리소스 인덱싱 방지

메타 태그를 사용하면 페이지 인덱싱을 방지하는 역할을 할 수 있다.

그러나 PDF 및 이미지와 같은 리소스에는 제대로 작동하지 않는다.

따라서 Robots.txt 크롤링 차단을 하는 것이 좋다.

그럼 어떻게 활용할 수 있을까?

Robots.txt 활용 방법 4가지

1. Robots.txt 파일 만들기

첫 번째는 실제로 Robots.txt 만들기를 하는 것이다.

텍스트 파일로 만들면 되는데, 어떤 방식으로든 상관 없다.

형식은 동일하다.

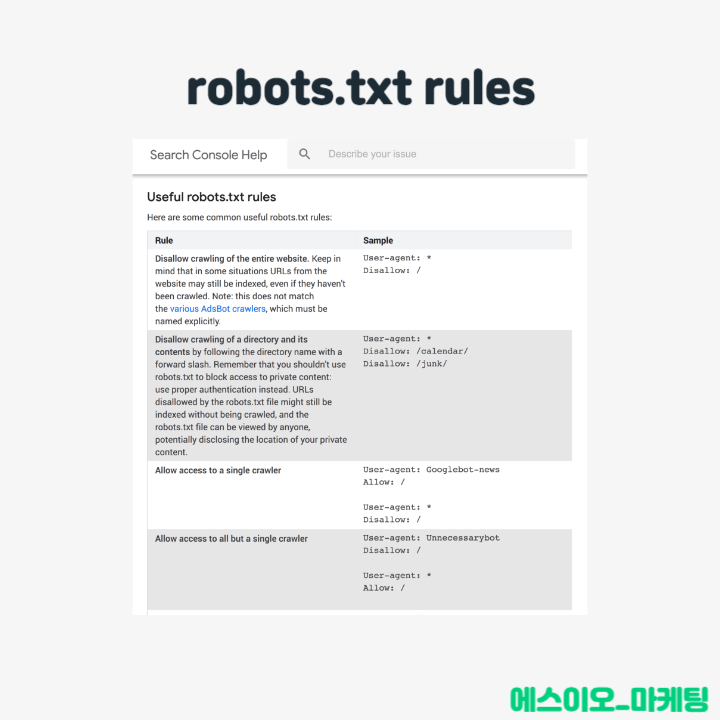

User-agent: X

Disallow: Y

User-agent는 봇을 말한다.

Disallow는 차단하려는 페이지나 섹션을 말한다.

그럼 구글 봇을 대상으로 차단을 해보자.

User-agent: googlebot

Disallow: /images

이 규칙은 구글봇이 웹사이트 이미지 폴더에 대한 색인을 하지 않도록 하는 것이다.

별표(*)를 사용하여 웹사이트 방문하는 모든 봇과 대화도 가능하다.

더 자세한 내용은 구글에서 확인이 가능하다.

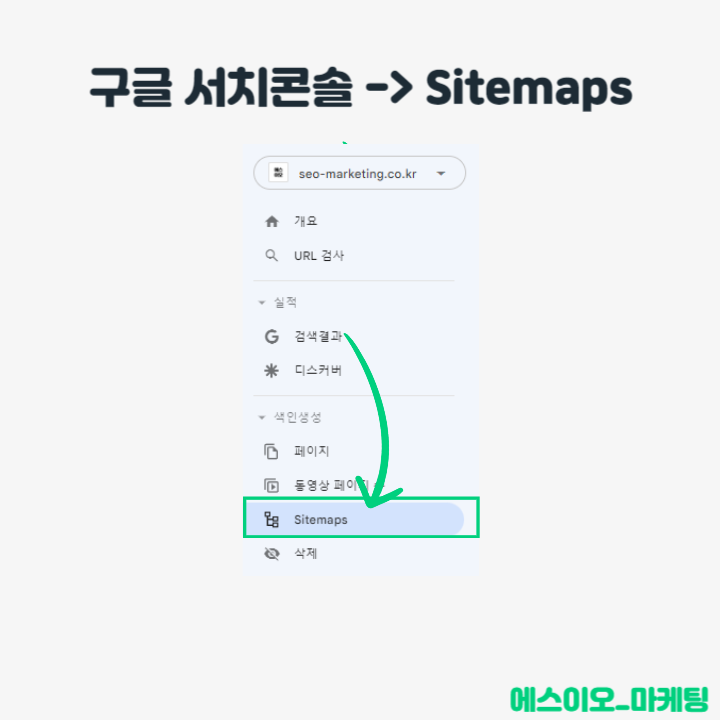

2. Robots.txt 파일을 찾도록 만들자

Robots.txt 파일이 있으면 활성화 해야 한다.

기본 디렉터리에 배치할 수 있다.

https://example.com/robots.txt

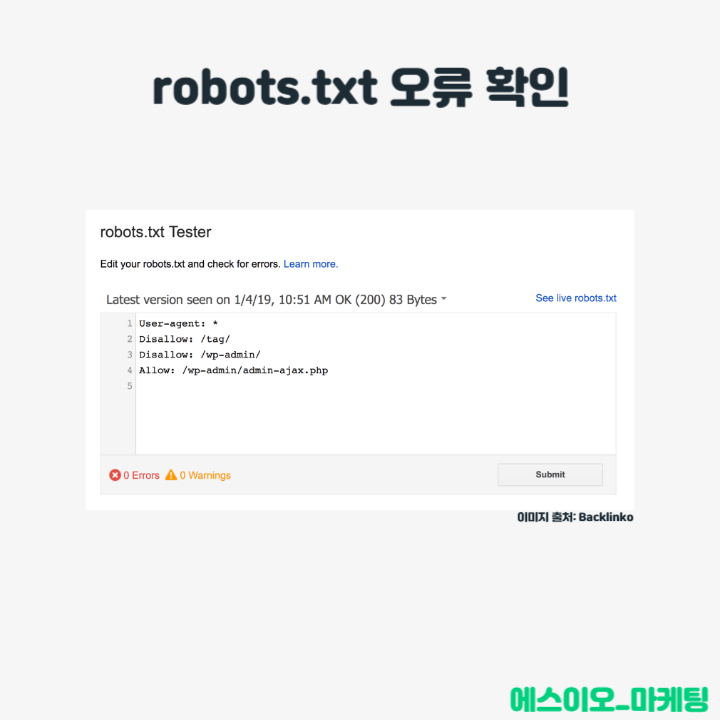

3. 오류 확인

Robots.txt 파일을 올바르게 설정하는 것이 중요하다.

한 번의 실수로 전체 사이트 색인이 떨어질 수 있기 때문이다.

따라서 실행하기 전에 테스트를 먼저 진행하자.

4. Robots.txt 및 메타 태그

‘noindex’ 메타 태그를 사용하여 페이지 수준에서 페이지를 차단할 수 있다.

하지만 이미지나 동영상과 같은 리소스에 구현하기 까다롭기 때문에, Robots.txt를 사용한다.

사용할 줄만 안다면 섞어서 사용해도 좋다.

더 알아보기

에스이오 부트캠프_30일 : SEO Analyst에게 구글 SEO를 A to Z까지 30일 동안 1:1로 배울 수 있는 강의.

에스이오_검색엔진 최적화 7가지 : 2019년부터 쌓아온 SEO를 정석으로 배울 수 있는 전자책.

에스이오 컨설팅 문의 : SEO Analyst가 함께하는 SEO 전략 전문 컨설팅.

연관 포스트