Robots.txt는 무엇인가?

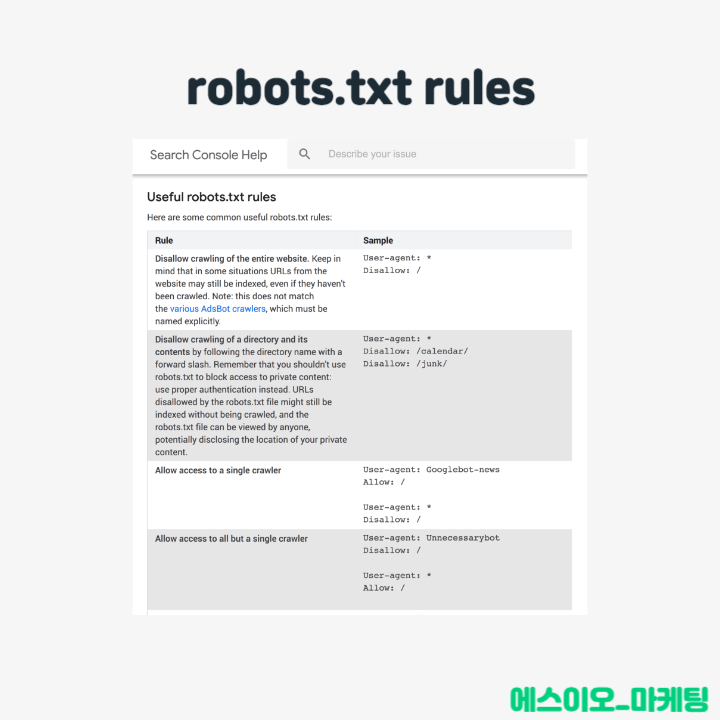

Robots.txt는 무엇인가? Robots.txt란 검색 엔진 스파이더에게 웹사이트 특정 페이지나 섹션을 크롤링하지 않도록 지시하는 파일이다. 대부분 주요 검색 엔진 구글, 빙, 네이버 등은 Robots.txt 요청을 인식한다. Robots.txt가 중요한 이유 대부분 웹사이트는 robots.txt 파일이 필요하지 않는다. 구글이 사이트의 모든 페이지를 찾아 색인을 생성할 수 있기 때문이다. 중요하지 않은 페이지나 중복 페이지는 자동으로 색인화하지 않는다. 하지만, Robots.txt를 사용하는…